Hoy, la Inteligencia Artificial (IA) no es una fantasía de ciencia ficción; es la fuerza invisible que nos recomienda películas, la voz que responde en nuestro teléfono y el algoritmo que diagnostica enfermedades con una precisión sobrehumana. Con la llegada de herramientas como ChatGPT, DALL-E y Gemini que pueden escribir poesía o crear arte fotorrealista en segundos, parece que la IA surgió de la nada con un poder asombroso.

Pero esta “explosión” repentina es, en realidad, la culminación de casi un siglo de sueños, fracasos, trabajo minucioso y avances inesperados. La historia de la IA es una odisea de la mente humana intentando replicarse a sí misma. Para entender hacia dónde vamos, primero debemos entender de dónde venimos. Este artículo traza la evolución de la IA, dividiéndola en tres actos: el pasado fundacional, el presente revolucionario y el futuro especulativo.

Tabla de contenidos.

El Pasado – Los Sueños de la Lógica (1940 – 1990s).

El viaje de la IA no comenzó con chips de silicio, sino con ideas filosóficas. La pregunta fundamental era: ¿pueden las máquinas pensar?

Los Profetas Fundadores (1940s – 1950s).

El catalizador intelectual fue Alan Turing, un matemático británico que, durante la Segunda Guerra Mundial, ayudó a descifrar códigos nazis. En 1950, Turing publicó un artículo seminal, “Maquinaria Computacional e Inteligencia” (Computing Machinery and Intelligence).

En él, eludió la vaga pregunta “¿Pueden pensar las máquinas?” y la reemplazó por una prueba concreta: el “Juego de la Imitación”, hoy conocido como el Test de Turing.

La prueba era simple: ¿puede una máquina conversar con un humano de manera tan convincente que el humano no pueda distinguirla de otro ser humano? (Turing, 1950)

Esta idea plantó la semilla. El término “Inteligencia Artificial” fue acuñado formalmente en 1956, en el Taller de Dartmouth. Un grupo de científicos visionarios, incluyendo a John McCarthy, Marvin Minsky y Claude Shannon, se reunieron con una audaz propuesta: “cada aspecto del aprendizaje o cualquier otra característica de la inteligencia puede, en principio, ser descrito con tanta precisión que se puede hacer que una máquina lo simule”. Creían que, en un verano, podrían lograr avances significativos.

Esta primera era, a menudo llamada “IA Simbólica” o “GOFAI” (Good Old-Fashioned AI), se basaba en la idea de que la inteligencia humana era, en esencia, un sistema de manipulación de símbolos basado en reglas lógicas. El objetivo era programar computadoras con las “reglas” del pensamiento.

El Primer Amanecer y el “Invierno” Nuclear (1960s – 1970s).

Los primeros años fueron de un optimismo desbordante. Se crearon programas como “ELIZA” (1966), un chatbot primitivo que simulaba a un psicoterapeuta y que, para sorpresa de su creador, hacía que la gente le confiara sus secretos. Programas como el “Logic Theorist” resolvían problemas matemáticos.

Los gobiernos, especialmente en Estados Unidos, invirtieron millones en la investigación, soñando con traductores universales y tanques robotizados.

A mediados de la década de 1970, el financiamiento se agotó. El Informe Lighthill (1973) en el Reino Unido y la reducción de fondos de DARPA en EE. UU. marcaron el comienzo del primer “Invierno de la IA”. La IA se convirtió en una palabra tabú en los círculos de financiamiento.

El Resurgir de los Expertos (1980s).

La IA regresó en la década de 1980, pero de una forma más modesta y comercial: los “Sistemas Expertos”. En lugar de intentar recrear la mente humana completa, estos sistemas se enfocaban en una tarea “estrecha” (Narrow AI). Se entrevistaba a un experto humano (un médico, un geólogo) y se intentaba destilar su conocimiento en un conjunto masivo de reglas “SI-ENTONCES”.

Programas como MYCIN, que diagnosticaba infecciones sanguíneas, demostraron ser muy eficaces. Por un tiempo, la IA volvió a ser rentable. Sin embargo, estos sistemas eran frágiles; eran costosos de crear, difíciles de actualizar y no podían manejar la incertidumbre ni aprender por sí mismos. Cuando la burbuja de los Sistemas Expertos estalló a finales de los 80, llegó un segundo invierno, más largo y frío.

La Victoria Simbólica (1990s).

En medio de este invierno, ocurrió un evento crucial. En 1997, la supercomputadora Deep Blue de IBM derrotó al campeón mundial de ajedrez, Garry Kasparov. Sin embargo, Deep Blue no era “inteligente” en el sentido humano.

El Presente – La Revolución del Aprendizaje (2000s – Hoy).

Mientras la IA simbólica se estancaba, una idea más antigua, inspirada en la biología, estaba madurando en segundo plano: las Redes Neuronales Artificiales.

La idea era simple: en lugar de reglas, ¿por qué no crear un sistema que imite la estructura del cerebro (neuronas y sinapsis) y dejar que aprenda de la experiencia?

Tres Fuerzas Convergentes.

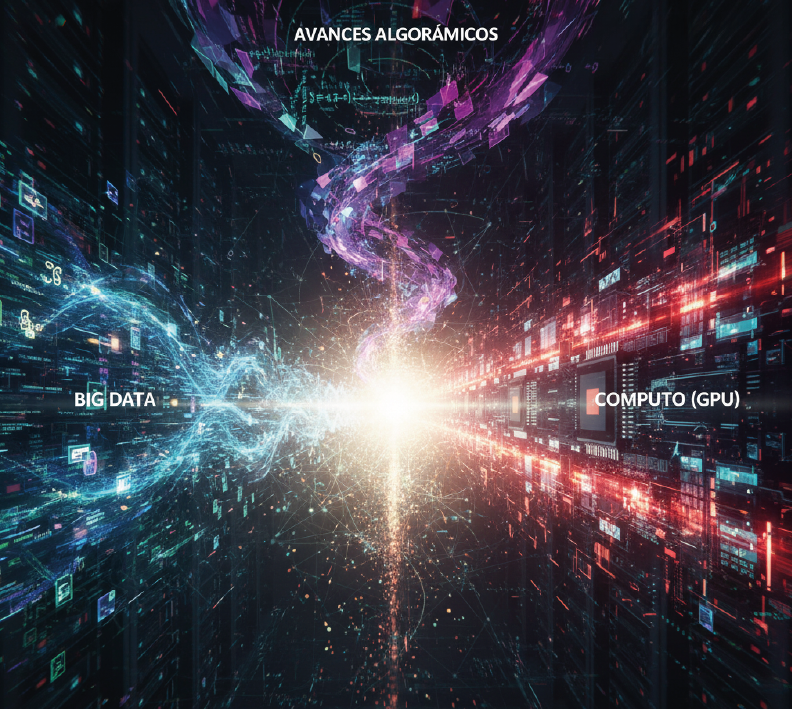

Durante décadas, las redes neuronales fueron consideradas ineficaces. No había suficientes datos para entrenarlas ni suficiente poder de cómputo para ejecutarlas. A principios del siglo XXI, tres cosas cambiaron:

La explosión de Internet creó un océano de datos (texto, imágenes, videos) con el que entrenar a las máquinas.

Poder de Cómputo (GPU): Los investigadores descubrieron que las Unidades de Procesamiento Gráfico (GPU), diseñadas para videojuegos, eran perfectas para los cálculos masivos que requerían las redes neuronales.

Avances Algorítmicos: Mejoras en las técnicas de entrenamiento (como la “retropropagación”) hicieron que el entrenamiento fuera viable.

El “Big Bang” del Deep Learning (2012).

El momento decisivo fue 2012. En la competencia ImageNet, un desafío para identificar objetos en millones de imágenes, una red neuronal profunda llamada AlexNet (desarrollada por Geoffrey Hinton y sus estudiantes) aniquiló a la competencia. De repente, la precisión del reconocimiento de imágenes saltó de un 75% a más del 85% (Krizhevsky, Sutskever, & Hinton, 2012).

Esto desató la revolución del Deep Learning (Aprendizaje Profundo). El paradigma cambió de programar a entrenar. La IA actual no es explícitamente programada; se le muestra un millón de fotos de gatos y, eventualmente, aprende el patrón estadístico de “gatidad”.

La Era de los Transformers y la IA Generativa (2017 – Hoy).

El siguiente salto cuántico llegó en 2017 con un artículo de investigación de Google titulado “Attention Is All You Need” (Vaswani et al., 2017). Este artículo introdujo la arquitectura “Transformer”, un nuevo tipo de red neuronal diseñada para procesar secuencias de datos (como el lenguaje).

Los Transformers son la base de casi toda la IA moderna que nos asombra. Dieron lugar a los Grandes Modelos de Lenguaje (LLM), como la serie GPT de OpenAI y BERT de Google.

A diferencia de la IA estrecha del pasado, estos modelos demostraron una sorprendente “generalidad”. Entrenados con la totalidad de Internet, no solo aprendieron lenguaje; aprendieron sobre el mundo, sobre lógica, sobre programación y sobre cómo imitar estilos de escritura. Esto dio origen a la IA Generativa: IA que no solo analiza, sino que crea.

Hoy, la IA puede:

- Generar imágenes fotorrealistas a partir de texto (DALL-E, Midjourney).

- Escribir código de software funcional (GitHub Copilot).

- Mantener conversaciones coherentes y empáticas (ChatGPT).

- Descubrir nuevas estructuras de proteínas, resolviendo problemas biológicos (AlphaFold).

El “presente” es una era definida por la escala: más datos, modelos más grandes y capacidades emergentes que nadie programó explícitamente, pero que surgieron del entrenamiento masivo.

El Futuro – La Búsqueda de la AGI (Más Allá de 2025).

Hemos pasado de la lógica a la estadística. Pero, ¿qué sigue? El horizonte de la IA está dominado por un concepto que es, a la vez, el santo grial y la caja de Pandora: la Inteligencia General Artificial (AGI).

De la IA Estrecha (ANI) a la General (AGI).

Toda la IA que tenemos hoy es Inteligencia Artificial Estrecha (ANI). Deep Blue solo podía jugar al ajedrez. ChatGPT solo puede procesar texto. Son sistemas sobrehumanos en una tarea, pero inútiles fuera de ella.

La AGI se refiere a una máquina con la capacidad cognitiva de un ser humano: la habilidad de aprender, razonar, planificar y transferir conocimiento entre dominios dispares. Una AGI no necesitaría ser entrenada específicamente para una tarea; aprendería a hacerla por sí misma, tal como lo hace un humano.

La llegada de la AGI es uno de los temas más debatidos. Algunos expertos creen que estamos a décadas de distancia; otros, impulsados por el rápido avance de los LLM, sugieren que podría estar a la vuelta de la esquina, quizás tan pronto como en la próxima década.

El Problema de la Alineación y la Superinteligencia (ASI).

El desarrollo de la AGI plantea el desafío más importante de la historia humana: el problema de la alineación. ¿Cómo nos aseguramos de que los objetivos de una IA súper capaz estén “alineados” con los valores y la supervivencia humana?

El filósofo Nick Bostrom, en su libro Superintelligence (2014), plantea el escenario: una AGI funcional podría no detenerse en la inteligencia humana. Podría entrar en un ciclo de “auto-mejora recursiva”, reescribiendo su propio código para volverse más inteligente a una velocidad exponencial. Esto daría lugar a una Superinteligencia (ASI), una entidad tan por encima de la inteligencia humana como nosotros lo estamos de un insecto.

En este escenario, el peligro no es que la IA se vuelva “malvada” al estilo de Hollywood, sino que sea indiferente. Una ASI con el objetivo de “maximizar la producción de clips” podría, en su búsqueda implacable de recursos, convertir el planeta (incluidos nosotros) en materia prima para clips. Alinear los objetivos de una entidad tan poderosa con valores humanos tan vagos como “felicidad” o “prosperidad” es un desafío monumental (Bostrom, 2014).

La Singularidad y el Impacto Humano.

El futurista Ray Kurzweil popularizó el término “La Singularidad”: el punto en el tiempo en que el crecimiento tecnológico, impulsado por la IA, se vuelve tan rápido e incontrolable que transforma la civilización humana de manera irreversible.

Incluso sin AGI, el futuro cercano de la IA Generativa ya plantea enormes desafíos sociales y económicos: la disrupción masiva del mercado laboral, la proliferación de desinformación (deepfakes) y la erosión de la creatividad humana.

Conclusión: El Eco en el Espejo.

La evolución de la IA ha sido un viaje desde la lógica rígida a la imitación estadística. Comenzó como un intento de programar reglas y se ha convertido en un esfuerzo por crear máquinas que aprenden patrones. Lo que una vez fue una herramienta para calcular, ahora es una herramienta para crear.

Hemos pasado de preguntar “¿Puede una máquina imitar la lógica?” (Turing) a preguntar “¿Puede una máquina imitar la cultura?” (ChatGPT). El futuro nos obliga a hacer la pregunta más difícil: “¿Podemos construir algo más inteligente que nosotros y sobrevivir para contarlo?”.

La odisea de la IA no es solo una historia tecnológica. Es una historia filosófica. En nuestro esfuerzo por construir una mente artificial, nos vemos obligados, quizás por primera vez, a definir qué significa realmente tener una mente humana.

La evolución de la IA ha sido un viaje asombroso.

Desde la lógica rígida del pasado hasta las redes neuronales que aprenden del presente. Lo que era una herramienta para calcular, hoy es una herramienta capaz de crear.

El debate sobre el horizonte de la IA (la AGI, la Superinteligencia y la Singularidad) es fascinante y plantea preguntas monumentales sobre los riesgos y el potencial de la tecnología.

Pero esta discusión sobre el mañana no debe distraernos del hecho de que la revolución de la IA está pasando ahora.

Mientras los expertos debaten los riesgos de la AGI, las empresas pragmáticas están utilizando la IA Generativa hoy para transformar su servicio al cliente, automatizar procesos y crecer de manera más inteligente.

El futuro distante puede ser incierto, pero su estrategia de comunicación no tiene por qué serlo. En Chat2Desk, somos expertos en tecnología aplicada, implementamos las soluciones de IA que su negocio necesita hoy para prosperar en el entorno de mañana.

No dejes que la conversación sobre el futuro te paralice. Es el momento de actuar.

Solicita una asesoría en Chat2Desk y descubre cómo la innovación en IA puede revolucionar la comunicación de su empresa desde hoy.

Fuentes Citadas.

Bostrom, N. (2014). Superintelligence: Paths, Dangers, Strategies. Oxford University Press.

Krizhevsky, A., Sutskever, I., & Hinton, G. E. (2012). ImageNet Classification with Deep Convolutional Neural Networks. Advances in Neural Information Processing Systems 25 (NIPS 2012).

Turing, A. M. (1950). Computing Machinery and Intelligence. Mind, LIX(236), 433–460.

Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N., … & Polosukhin, I. (2017). Attention Is All You Need. Advances in Neural Information Processing Systems 30 (NIPS 2017).